本文的作者是博主的一位发小。

半年前,hl 回清华,我们一同在五道口的意大利面馆吃了一顿,饭后一路走回学校。我动议他回老宿舍看看,他欣然接受。还记得他站在窗前向北眺望夜景——北边是校外,成片的郊野公园与圆明园相接。谁能想到这位公子哥离校那年和离校后发生这么多事情呢?我们在 23 年都受到巨大的精神挑战,其剧烈程度,几近将我们打倒不起。看他眺望窗外的背影,我说:“你果然没有那种重回故地的慨叹”,他同意。这几年,可以慨叹的事情太多了吧!

代码如诗

本文的作者是博主的一位发小。

半年前,hl 回清华,我们一同在五道口的意大利面馆吃了一顿,饭后一路走回学校。我动议他回老宿舍看看,他欣然接受。还记得他站在窗前向北眺望夜景——北边是校外,成片的郊野公园与圆明园相接。谁能想到这位公子哥离校那年和离校后发生这么多事情呢?我们在 23 年都受到巨大的精神挑战,其剧烈程度,几近将我们打倒不起。看他眺望窗外的背影,我说:“你果然没有那种重回故地的慨叹”,他同意。这几年,可以慨叹的事情太多了吧!

今天,我发现我的星展银行(新加坡)的信用卡中有一笔莫名其妙的账单。于是我立刻跟星展银行的客服取得了联系,并且协助我撤销这笔 “盗刷交易”。在中国用了这么多年的支付宝和微信支付,从来没有遇到过未授权交易的情况,而有了信用卡的这几年间,这已经是我第二次遇到这种情况了。

我就是 vczh 口中那个 “中学时花了 100 小时编程” 的孩子。高考后,在物理老师邓华的推荐下,我选择了计算机专业。进入行业后我也曾焦虑:万一哪天干不动、不想写代码了怎么办?vczh 的这篇文章告诉了我答案:如果有一天你变得不喜欢编程了,那就不要编程。人生在世除了让自己开心,没有什么是必须做的。

本文全文转载自 @geniusvczh 在 2025 年 6 月 16 日发布的 X.com 文章,排版格式略有调整

又到了每年选志愿的时候。一个想法是否经得起时间的考验,就要看他是否不会跟着总路线一起摇摆。虽然每次的措辞不一样,但是我现在跟码农行业如日中天的 10 年前保持差不多的想法:一个人只要在中学阶段能花超过 100 个小时编程,我就认为他可以安心报计算机,为什么呢?

在消息推送服务 Pushover 的文档中,介绍了消息共有 5 种不同的优先级别(-2、-1、0、1 与 2)。这些级别对应了不同的消息推送模式,本篇文章对这些消息级别进行讨论。

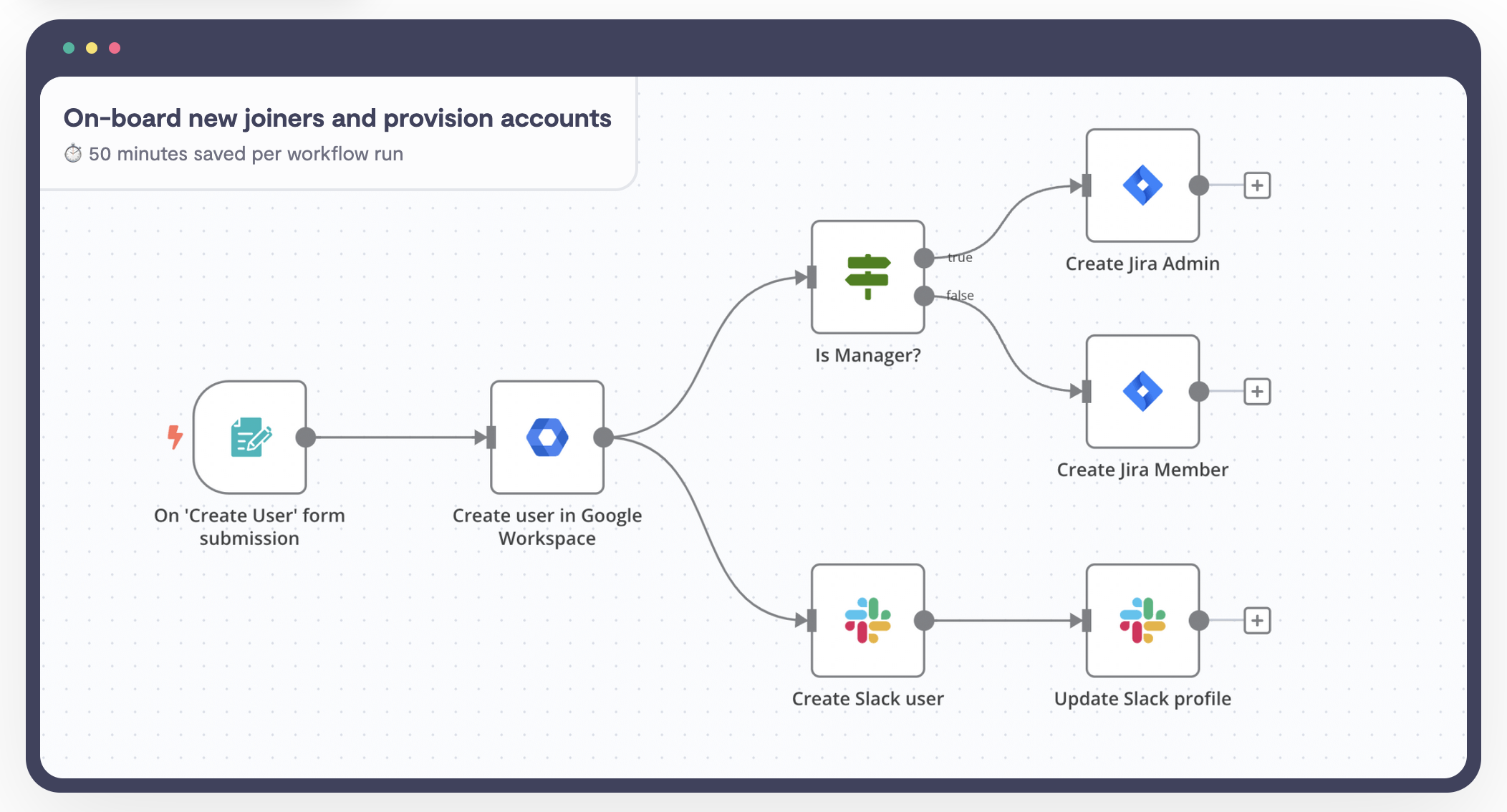

我们也许已经使用过一些自动化工作流的服务或工具,如 IFTTT 或 iOS 系统中的快捷指令。这些服务可在某些事件发生时,自动按照预设好的逻辑执行对应的指令——“在股票价格涨至 XX 时提醒我卖出”,又或者 “每天早上 9:00 自动进行软件每日签到”,都可以通过这些工具来轻松实现,就像部署了一个个人助理一样。

这些工具有着各自的局限性。例如 IFTTT 的免费版本仅提供了 3 条激活的工作流配额,超出的部分需要付费月度订阅。而 iOS 中的快捷指令则依赖于手机本身,当设备网络断开或者电量耗尽时,相关指令便不再执行。本文介绍了一款可在本地部署的工作流软件 n8n,该软件提供了强大的无代码或低代码工作流配置功能,能实现从简单到复杂的自动化工作流的能力,并可以配置和调用外部大语言模型作为 AI Agent(代理型人工智能)来完成智能判断和工具调用等功能。

又是一个不眠夜。

自从上一篇博客以来已经有大半年没有动笔来写文章了。因为总有许多工作要处理,而除此之外,有更多让我沉迷的事情。但今天是一个好的机会,虽然失眠的日子越来越少(这是好事),但是在这难得的氛围里,我终于又能撰写这一年的年终总结了。

本文的作者是费轩。

在黔追寻阳明行迹的六天里,最常听到的问题便是“阳明学对现代人的精神内耗能够起到什么作用?”其实,如果阳明只是一位古圣人,那么便无法对沦没于无聊日常生活的今人有什么借鉴意义,因为史诗、传奇的时代已经一去不复返了。然而,我却愿意将阳明视为我们的同时代人。王阳明在明代中期的政治 – 生存处境中,深刻地遭遇到个体性危机,作为一位敏锐的思想家和严肃的行动者,他以全副身心性命面对这一历史变局,阳明学便是这一历程的思想产物。

本文最后更新于 2024 年 3 月 29 日

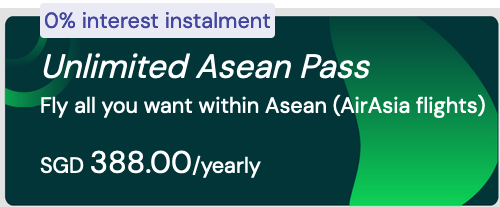

来自马来西亚的亚洲航空(AirAsia)近日推出了他们继 2022 年 SUPER+ 无限飞行年度计划之后的又一个年度订阅计划 AirAsia Unlimited Asean Pass(亚航东盟无限飞)。和上一年度的订阅计划不同,这一次的计划订阅费用变得更贵,并且仅限于在东盟国家的 69 条航线内的指定日期的航班内选择(要知道,去年的套餐是可以全球范围飞行的!)。然而抱着折腾不止的心态,我还是毅然决然购买了他们的年度飞行计划,踏上了一条折腾不止的不归路……

友情提示:这个计划本身有很多很坑的地方,如果没有做好折腾的准备,千万不要购买!

年终总结可能会迟到,但它从来不会缺席。

在过去的一年里,我和 Minda 探索了许多地方:新加坡、马来西亚、香港、马尔代夫、上海、布里斯班、北京。这比我过往任何一年的经历都要丰富。有些地方是之前从没来过,全新探索的。而另一些则是故地重游,顺便感受一下发展的新气象。而在旅途中时常让我感动的,其实大概率不是风景,而是人。有幸能够跟各种人交流,倾听他们的故事,近距离又真实地感受他们的情绪,走近他们的世界,这时常让我在内心热泪盈眶。